系统:centos7.0 64位minimal 虚拟机:VmwareWorkstation 14 Pro master:192.168.1.3 slave:192.168.1.4

点开,直接 设置好网络

设置密码 (slave与master同样设置)

1>进入/usr/ocal文件夹

[root@localhost master]# cd /usr/local2>创建tools文件夹

[root@localhost local]# mkdir -p tools3>进入tools文件夹

[root@localhost local]# cd tools4>进入oracle jdk下载网页,右键复制下载地址 http://download.oracle.com/otn-pub/java/jdk/8u161-b12/2f38c3b165be4555a1fa6e98c45e0808/jdk-8u161-linux-x64.tar.gz

5>下载JDK

[root@localhost tools]# wget --no-check-certificate --no-cookies --header "Cookie: Oraclelicense=accept-securebackup-cookie" http://download.oracle.com/otn-pub/java/jdk/8u161-b12/2f38c3b165be4555a1fa6e98c45e0808/jdk-8u161-linux-x64.tar.gz6>发现没有wget 先去下载wget

[root@localhost tools]# yum -y install wget7>解压缩

[root@localhost tools]# tar -zxvf jdk-8u161-linux-x64.tar.gz8>返回上一级并创建jdk文件夹

[root@localhost tools]# cd .. [root@localhost local]# mkdir -p jdk9>进入jdk文件夹,将刚才解压的jdk移动到jdk文件夹

[root@localhost local]# cd jdk [root@localhost jdk]# mv ../tools/jdk1.8.0_161/* .10>编辑配置文件并添加

[root@localhost jdk]# vi /etc/profile export JAVA_HOME=/usr/local/jdk export JRE_HOME=$JAVA_HOME/jre export CLASSPATH=$JAVA_HOME/lib:$JRE_HOME/lib export PATH=$JAVA_HOME/bin:$PATH:$JRE_HOME/bin保存退出,运行配置文件

[root@localhost jdk]# source /etc/profile11>测试java环境

[root@localhost jdk]# java -version java version "1.8.0_161" Java(TM) SE Runtime Environment (build 1.8.0_161-b12) Java HotSpot(TM) 64-Bit Server VM (build 25.161-b12, mixed mode)12> slave同上

1>在master上

[root@localhost ~]# ssh-keygen -t rsa一路回车,最终生成(id_rsa,id_rsa.pub两个文件) 2>把id_rsa.pub 复制到slave上去.

[root@localhost .ssh]# scp ~/.ssh/id_rsa.pub root@192.168.1.4:~/.ssh3>进入slave系统,生成authorized_keys. 如果没有.ssh文件夹则创建

[root@localhost .ssh]# cd ~/.ssh [root@localhost .ssh]# cat id_rsa.pub >> authorized_keys4>将生成的文件发送给master系统

[root@localhost .ssh]# scp ~/.ssh/authorized_keys root@192.168.1.3:~/.ssh5>修改配置文件并启动服务(master和slave)

[root@localhost .ssh]# vi /etc/ssh/sshd_config #禁用root账户登录,如果是用root用户登录请开启 PermitRootLogin yes保存后启动服务

[root@localhost .ssh]# /bin/systemctl start sshd.service以下皆在master上操作 1>进入/usr/local/tools目录

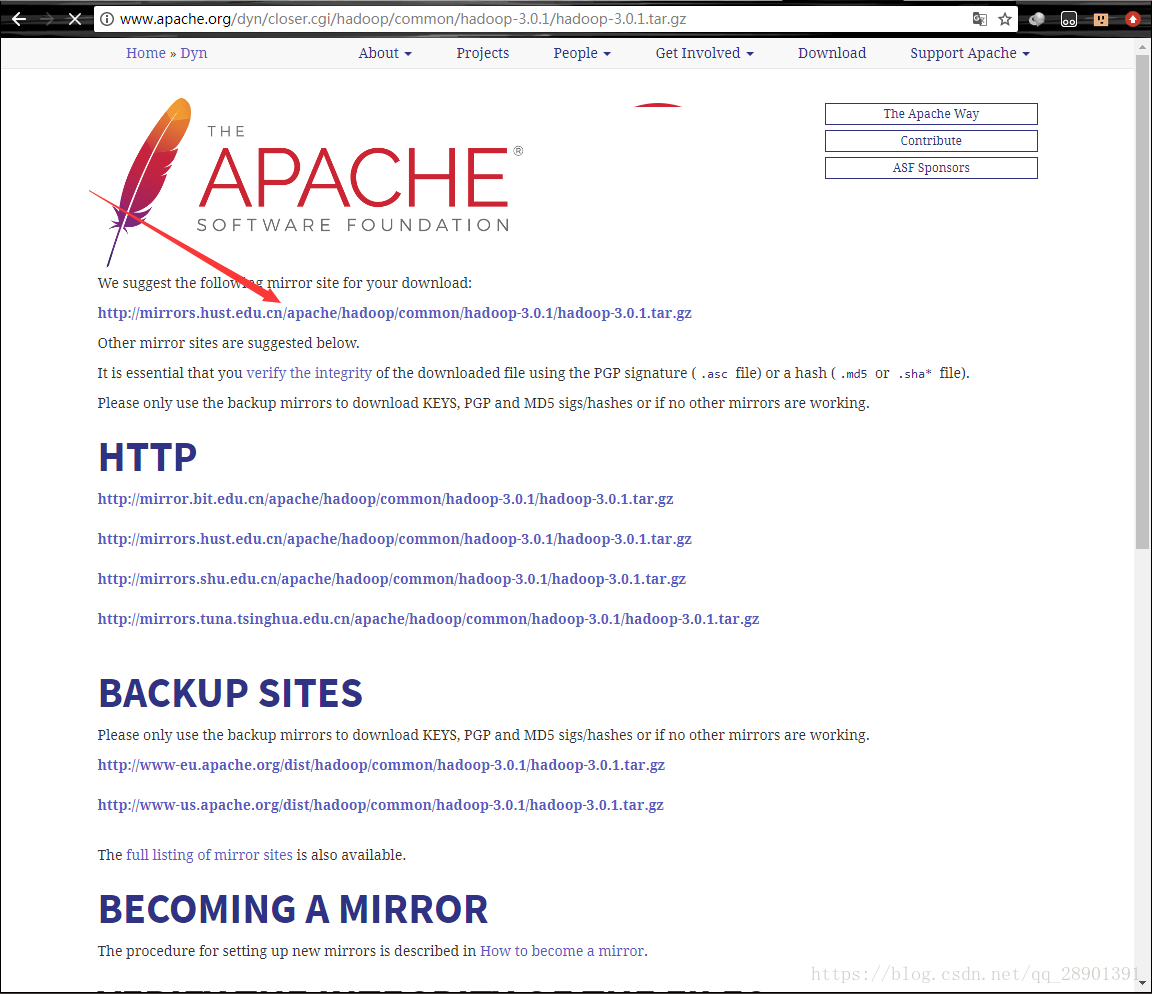

cd /usr/local/tools 进入hadoop官网,找到hadoop3.0.1下载地址  wget http://mirrors.hust.edu.cn/apache/hadoop/common/hadoop-3.0.1/hadoop-3.0.1.tar.gz 下载完成后解压 tar -zxvf hadoop-3.0.1.tar.gz 在/usr/local目录下创建hadoop文件夹,并将解压后的hadoop移动到新文件夹内 cd /usr/local mkdir -p hadoop cd hadoop mv ../tools/hadoop-3.0.1/* .2>配置环境变量 hadoop-env.sh(/usr/local/hadoop/etc/hadoop) 在文件中找到一行代码:

#export JAVA_HOME=$JAVA_HOME改为

export JAVA_HOME=/usr/local/jdk然后保存文件 3>配置核心组件 core-site.xml

<property> <name>hadoop.tmp.dir</name> <value>/usr/local/hadoop/data/tmp</value> </property> <property> <name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property>在/usr/local/hadoop目录下创建data文件夹,并在data文件夹下创建tmp文件夹。(略 4>配置核心组件hdfs-site.xml

<property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.permissions</name> <value>false</value> </property>5>配置核心组件yarn-site.xml

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property>6>配置核心组件mapred-site.xml

<property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>yarn.app.mapreduce.am.env</name> <value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value> </property> <property> <name>mapreduce.map.env</name> <value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value> </property> <property> <name>mapreduce.reduce.env</name> <value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value> </property>7>配置核心组件workers 添加节点名称(我的一个节点名为 slave)

slave8>配置环境变量/etc/profile master与slave都配置 在末尾添加:

export HADOOP_HOME=/usr/local/hadoop export HADOOP_PREFIX=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_YARN_HOME=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export YARN_CONF_DIR=$HADOOP_HOME/etc/hadoop export PATH=$PATH:$HADOOP_HOME/bin export PATH=$PATH:$HADOOP_HOME/sbin export HDFS_DATANODE_USER=root export HDFS_DATANODE_SECURE_USER=root export HDFS_SECONDARYNAMENODE_USER=root export HDFS_NAMENODE_USER=root export YARN_RESOURCEMANAGER_USER=root export YARN_NODEMANAGER_USER=root保存后,启动配置文件

source /etc/profile9>将配置完成的hadoop复制到slave上

scp -r /usr/local/hadoop root@192.168.1.4:/usr/local/改变master与slave的hostname 1>改hosts(master和slave同)

vi /etc/hosts删除所有内容,添加:

192.168.1.3 master 192.168.1.4 slave2>改/etc/sysconfig/network(master和slave分别改为不同的名字)

vi /etc/sysconfig/network添加:

HOSTNAME=master //命名随主机名改变最后重启master和slave

参考资料: 1 https://www.linuxidc.com/Linux/2016-06/132678.htm 2 https://blog.csdn.net/rlnLo2pNEfx9c/article/details/78816075